Благодарим за интерес к нашей работе. Вы также можете ознакомиться с нашими новыми обновлениями о миниатюрных моделях для аниме-изображений и видео в Real-ESRGAN

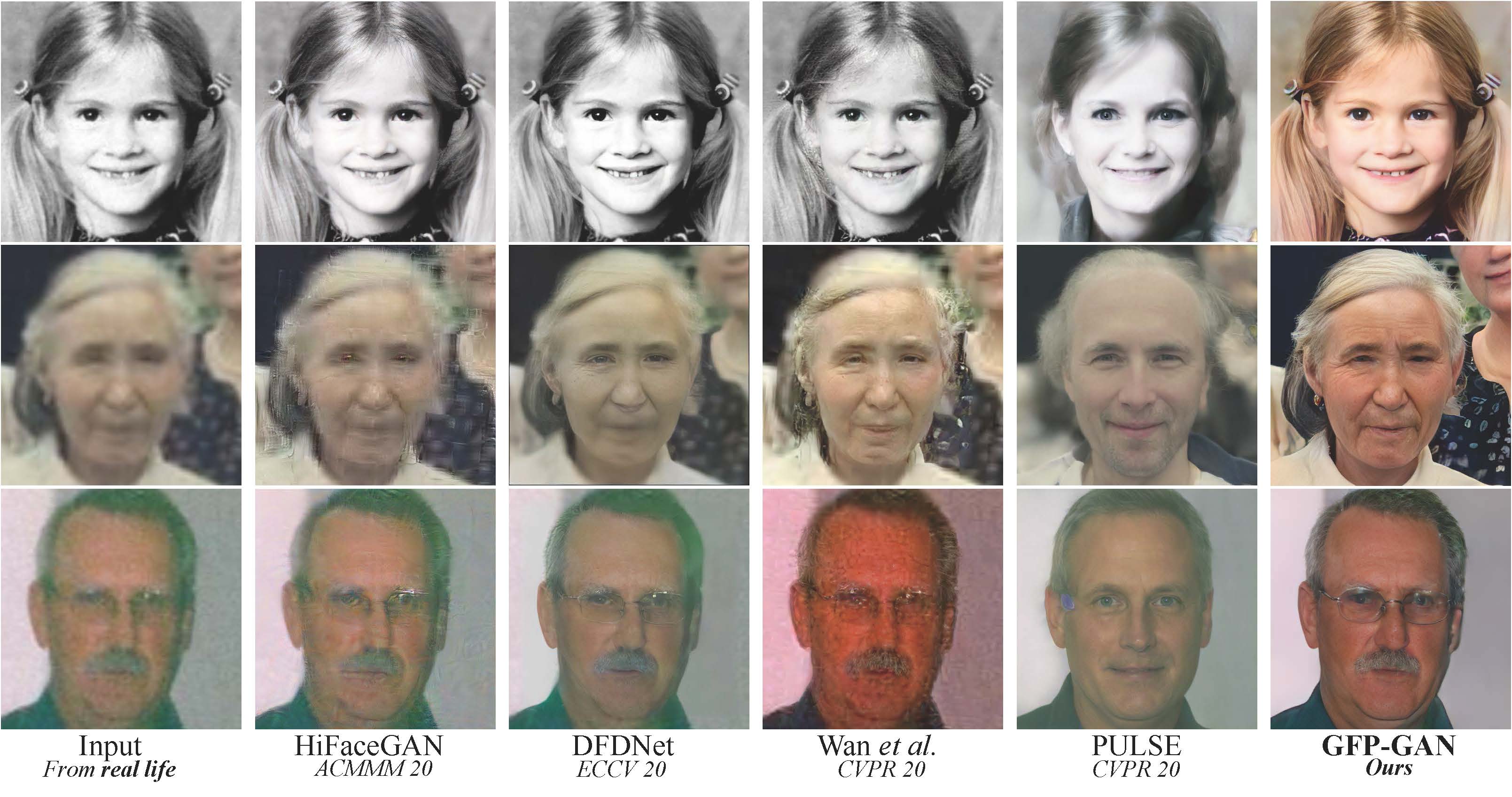

GFPGAN направлен на разработку практического алгоритма для восстановления лиц в реальных условиях. Он использует богатые и разнообразные априорные данные, заключённые в предварительно обученной GAN для лица (например, StyleGAN2), для слепого восстановления лица.

![]() Обновления

Обновления

Если GFPGAN полезен для ваших фотографий/проектов, пожалуйста, помогите поставить ![]() этому репозиторию или порекомендуйте его своим друзьям. Спасибо!

этому репозиторию или порекомендуйте его своим друзьям. Спасибо! ![]() Другие рекомендуемые проекты:

Другие рекомендуемые проекты:

![]() Real-ESRGAN: практический алгоритм для общего восстановления изображений.

Real-ESRGAN: практический алгоритм для общего восстановления изображений.

![]() BasicSR: набор инструментов с открытым исходным кодом для восстановления изображений и видео.

BasicSR: набор инструментов с открытым исходным кодом для восстановления изображений и видео.

![]() facexlib: коллекция, предоставляющая полезные функции, связанные с лицами.

facexlib: коллекция, предоставляющая полезные функции, связанные с лицами.

![]() HandyView: программа просмотра изображений на основе PyQt5, удобная для просмотра и сравнения.

HandyView: программа просмотра изображений на основе PyQt5, удобная для просмотра и сравнения.

[Paper] [Project Page] [Demo]

Xintao Wang, Yu Li, Honglun Zhang, Ying Shan

Applied Research Center (ARC), Tencent PCG

Установка

Мы предоставляем чистую версию GFPGAN, которая не требует специализированных расширений CUDA.

Если вы хотите использовать оригинальную модель из нашей статьи, см. PaperModel.md для установки.

Клонируйте репозиторий.

git clone https://github.com/TencentARC/GFPGAN.git

cd GFPGAN

Установите зависимые пакеты.

# Установите basicsr — https://github.com/xinntao/BasicSR

# Мы используем BasicSR как для обучения, так и для вывода

pip install basicsr

# Установите facexlib — https://github.com/xinntao/facexlib

# В пакете facexlib мы используем функции обнаружения лиц и восстановления лиц

pip install facexlib

pip install -r requirements.txt

python setup.py develop

# Если вы хотите улучшить фон (не лица) с помощью Real-ESRGAN,

# вам также необходимо установить пакет realesrgan

pip install realesrgan

Скачайте предварительно обученные модели: GFPGANCleanv1-NoCE-C2.pth (https://github.com/TencentARC/GFPGAN/releases/download/v0.2.0/GFPGANCleanv1-NoCE-C2.pth).

wget https://github.com/TencentARC/GFPGAN/releases/download/v0.2.0/GFPGANCleanv1-NoCE-C2.pth -P experiments/pretrained_models

Вывод!

python inference_gfpgan.py --upscale 2 --test_path inputs/whole_imgs --save_root results

Если вы хотите использовать исходную модель из нашей статьи, см. PaperModel.md для установки и вывода.

Вы можете найти больше моделей (например, дискриминаторы) здесь: [Google Drive], ИЛИ [Tencent Cloud 腾讯微云]

Мы предоставляем обучающие коды для GFPGAN (использованные в нашей статье).

Вы можете улучшить его в соответствии со своими потребностями.

Советы

Процедуры

(Вы можете попробовать простую версию (options/train_gfpgan_v1_simple.yml), которая не требует ориентиров компонентов лица.)

Подготовка набора данных: FFHQ (https://github.com/NVlabs/ffhq-dataset).

Скачайте предварительно обученные модели и другие данные. Поместите их в папку experiments/pretrained_models.

Измените файл конфигурации options/train_gfpgan_v1.yml соответствующим образом.

Обучение

python -m torch.distributed.launch --nproc_per_node=4 --master_port=22021 gfpgan/train.py -opt options/train_gfpgan_v1.yml --launcher pytorch

GFPGAN выпущен под лицензией Apache версии 2.0.

@InProceedings{wang2021gfpgan,

author = {Xintao Wang and Yu Li and Honglun Zhang and Ying Shan},

title = {Towards Real-World Blind Face Restoration with Generative Facial Prior},

booktitle={The IEEE Conference on Компьютерное зрение и распознавание образов (CVPR),

year = {2021}

Если у вас есть какие-либо вопросы, пожалуйста, напишите на адрес электронной почты xintao.wang@outlook.com или xintaowang@tencent.com.

Вы можете оставить комментарий после Вход в систему

Неприемлемый контент может быть отображен здесь и не будет показан на странице. Вы можете проверить и изменить его с помощью соответствующей функции редактирования.

Если вы подтверждаете, что содержание не содержит непристойной лексики/перенаправления на рекламу/насилия/вульгарной порнографии/нарушений/пиратства/ложного/незначительного или незаконного контента, связанного с национальными законами и предписаниями, вы можете нажать «Отправить» для подачи апелляции, и мы обработаем ее как можно скорее.

Комментарии ( 0 )