(русский|English)

------------------------------------------------------------------------------------PaddleSpeech — это открытая библиотека моделей для голосовых технологий, основанная на платформе PaddlePaddle. Она предназначена для разработки различных ключевых задач в области аудио и звука с использованием передовых и влиятельных моделей глубинного обучения. Некоторые типичные примеры применения представлены ниже:

PaddleSpeech получила NAACL2022 Best Demo Award, пожалуйста, посетите Arxiv статью.

| Входной аудио | Результат распознавания |

|---|---|

|

|

I knocked at the door on the ancient side of the building. |

|

|

Я считаю, что самое важное в бегах — это то, что они приносят мне здоровье. |

| Входной текст | Синтезированное аудио | ||||||||||||||||||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Жизнь — это как коробка шоколадов, ты никогда не знаешь, что получишь. |

|

||||||||||||||||||||||||||||||||||||

| Доброе утро, сегодня 2020/10/29, минимальная температура -3°C. |

|

||||||||||||||||||||||||||||||||||||

Жижи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. ЖиЖи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи. Жи жи жи, жи жи жи.```markdown

Восстановление знаков препинания

Основные характеристикиПроект был реализован с учётом удобства использования, эффективности, гибкости и возможности расширения, чтобы лучше поддерживать промышленные применения и академическое исследование. Реализованные функции включают модули обучения, вывода и тестирования, а также процесс развертывания, который включает:- 📦 Удобство использования: низкие требования к установке, возможность быстрого старта с помощью CLI.

Сканирование QR-кода через WeChat для подписки на официальный аккаунт, заполните анкету и присоединитесь к официальному общению, чтобы получить более эффективную помощь в решении вопросов и возможность общения со всеми участниками сообщества. Ждём вас!

УстановкаМы настоятельно рекомендуем пользователям установить PaddleSpeech в среде Linux с версией Python 3.8 и выше. В то же время, некоторые новые версии Paddle ещё не поддерживаются, поэтому можно использовать только версии до 2.5.1 включительно. Нужные зависимости

PaddleSpeech зависит от paddlepaddle, установка может быть выполнена с помощью официального сайта paddlepaddle, выбрав подходящую версию для вашего оборудования. Ниже представлен пример установки для CPU, остальные версии вы можете выбрать самостоятельно. pip install paddlepaddle -i https://mirror.baidu.com/pypi/simple

```Вы также можете установить конкретную версию paddlepaddle или версию develop.

```bash

# Установка версии 2.4.1. Обратите внимание: bkz 2.4.1 является примером, выберите минимально необходимую версию paddlepaddle.

pip install paddlepaddle==2.4.1 -i https://mirror.baidu.com/pypi/simple

# Установка версии develop

pip install paddlepaddle==0.0.0 -f https://www.paddlepaddle.org.cn/whl/linux/cpu-mkl/develop.html

Установка PaddleSpeech возможна двумя способами: через pip и компиляцию из исходников (рекомендуется). Установка через pippip install pytest-runner

pip install paddlespeech

Установка через компиляцию из исходниковgit clone https://github.com/PaddlePaddle/PaddleSpeech.git

cd PaddleSpeech

pip install pytest-runner

pip install .

Дополнительная информация по установке, такая как использование конфигураций conda, зависимостей librosa, проблем GCC и установки kaldi, доступна в этой документации по установке. Если возникли проблемы при установке, вы можете оставить свои вопросы здесь: #2150. Быстрый стартПосле завершения установки, разработчики могут быстро начать работу через командную строку или Python. В режиме командной строки можно менять параметр wget -c https://paddlespeech.bj.bcebos.com/PaddleAudio/zh.wav

wget -c https://paddlespeech.bj.bcebos.com/PaddleAudio/en.wav

Распознавание речи(Нажмите, чтобы развернуть) Открытая система распознавания речи на китайском языкеРаспознавание речи одним щелчком мыши через командную строку paddlespeech asr --lang zh --input zh.wav

Распознавание речи одним щелчком мыши через Python API >>> from paddlespeech.cli.asr.infer import ASRExecutor

>>> asr = ASRExecutor()

>>> result = asr(audio_file="zh.wav")

>>> print(result)

Я считаю, что самое важное в беге — это то, что он приносит мне здоровье

Генерация речиОткрытая система генерации речи на китайском языкеГенерирует аудиофайл со скоростью дискретизации 24 kHz в формате WAV Генерация речи одним щелчком мыши через командную строку paddlespeech tts --input "Привет, добро пожаловать в глубинные нейронные сети Baidu Paddle!" --output output.wav

Генерация речи одним щелчком мыши через Python API >>> from paddlespeech.cli.tts.infer import TTSExecutor

>>> tts = TTSExecutor()

>>> tts(text="Сегодня погода просто отличная.", output="output.wav")

Классификация звуковИнструмент классификации звука для различных сценариевМодели классификации звука на основе набора данных AudioSet, содержащего 527 классовОдним щелчком мыши через командную строку paddlespeech cls --input zh.wav

Одним щелчком мыши через Python API >>> from paddlespeech.cli.cls.infer import CLSExecutor

>>> cls = CLSExecutor()

>>> result = cls(audio_file="zh.wav")

>>> print(result)

{'Speech': 0.9027186632156372}

Экстракция голосового отпечаткаПрофессиональный инструмент экстракции голосового отпечаткаОдним щелчком мыши через командную строку paddlespeech vector --task spk --input zh.wav

Python API однокликовый прогноз >>> from paddlespeech.cli.vector import VectorExecutor

>>> vec = VectorExecutor()

>>> result = vec(audio_file="zh.wav")

>>> print(result) # 187-мерный вектор

[-0.19083306, 9.474295, -14.122263, -2.0916545, 0.04848729,

4.9295826, 1.4780062, 0.3733844, 10.695862, 3.2697146,

-4.48199, -0.6617882, -9.170393, -11.1568775, -1.2358263...]

Восстановление пунктуацииОднокликовый восстановитель пунктуации текста, который можно использовать вместе с моделью ASRОднокликовый запуск через командную строку paddlespeech text --task punc --input 今天的天气真不错啊你下午有空吗我想约你一起去吃饭

Python API однокликовый прогноз >>> from paddlespeech.cli.text.infer import TextExecutor

>>> text_punc = TextExecutor()

>>> result = text_punc(text="今天的天气真不错啊你下午有空吗我想约你一起去吃饭")

>>> print(result)

今天的天气真不错啊!你下午有空吗?我想约你一起去吃饭。

Голосовой переводКонечная-конечная система перевода английского голоса на китайский языкИспользует предварительно скомпилированные инструменты Kaldi, поддерживаются только на системах UbuntuОднокликовый запуск через командную строку paddlespeech st --input en.wav

Python API однокликовый прогноз >>> from paddlespeech.cli.st.infer import STExecutor

>>> st = STExecutor()

>>> result = st(audio_file="en.wav")

['I am here, on the old door of this building, knocking.']

Быстрый запуск сервисовПосле установки разработчики могут запустить различные службы, такие как распознавание речи, синтез речи, классификация аудио и т.д., используя одну команду. Вы можете быстро протестировать это в AI Studio: SpeechServer однокликовый запуск Запуск службы paddlespeech_server start --config_file ./demos/speech_server/conf/application.yaml

Доступ к службе распознавания речи paddlespeech_client asr --server_ip 127.0.0.1 --port 8090 --input input_16k.wav

Доступ к службе синтеза речи paddlespeech_client tts --server_ip 127.0.0.1 --port 8090 --input "Hello, welcome to the speech synthesis service from Baidu PaddlePaddle." --output output.wav

Доступ к службе классификации аудио paddlespeech_client cls --server_ip 127.0.0.1 --port 8090 --input input.wav

Дополнительная информация о командной строке для работы с сервисами, см. в разделе demos Быстрый старт поточного сервисаРазработчики могут попробовать использовать поточный ASR и поточный TTS сервисы.Запуск поточного ASR сервиса paddlespeech_server start --config_file ./demos/streaming_asr_server/conf/application.yaml

Обращение к поточному ASR сервису paddlespeech_client asr_online --server_ip 127.0.0.1 --port 8090 --input input_16k.wav

Запуск поточного TTS сервиса paddlespeech_server start --config_file ./demos/streaming_tts_server/conf/tts_online_application.yaml

Обращение к поточному TTS сервису paddlespeech_client tts_online --server_ip 127.0.0.1 --port 8092 --protocol http --input "Привет, добро пожаловать в сервис синтеза речи от Baidu PaddlePaddle." --output output.wav

Дополнительная информация доступна здесь: поточный ASR и поточный TTS Список моделейPaddleSpeech поддерживает множество популярных моделей и предоставляет предобученные модели, подробнее см. список моделей. Функционал распознавания речи в PaddleSpeech включает акустическую модель распознавания речи, лингвистическую модель распознавания речи и перевод речи, подробнее см. ниже:

|

FAT + Transformer + ASR MTL | fat-st-ted | |||||||||||||||||||||||||||||||||||

| Тип модуля синтеза речи | Тип модели | Датасет | Скрипт |

|---|---|---|---|

| Текстовый фронтенд | tn / g2p | ||

| Акустическая модель | Tacotron2 | LJSpeech / CSMSC | tacotron2-ljspeech / tacotron2-csmsc |

| Transformer TTS | LJSpeech | transformer-ljspeech | |

| SpeedySpeech | CSMSC | speedyspeech-csmsc | |

| FastSpeech2 | LJSpeech / VCTK / CSMSC / AISHELL-3 / ZH_EN / fine-tuning | fastspeech2-ljspeech / fastspeech2-vctk / fastspeech2-csmsc / fastspeech2-aishell3 / fastspeech2-zh_en / fastspeech2-fine-tuning | |

| ERNIE-SAT | VCTK / AISHELL-3 / ZH_EN | ERNIE-SAT-vctk / ERNIE-SAT-aishell3 / ERNIE-SAT-zh_en | |

| DiffSinger | Opencpop | diffsinger-opencpop | |

| Задача | Датасет | Тип модели | Скрипт |

|---|---|---|---|

| Классификация звука | ESC-50 | PANN | pann-esc50 |

| Задача | Датасет | Тип модели | Скрипт |

|---|---|---|---|

| Разбудить голосом | hey-snips | MDTC | mdtc-hey-snips |

| Задача | Датасет | Тип модели | Скрипт |

|---|---|---|---|

| Идентификация голоса | VoxCeleb1/2 | ECAPA-TDNN | ecapa-tdnn-voxceleb12 |

| Задача | Датасет | Тип модели | Скрипт |

|---|---|---|---|

| Журнал говорящих лиц | AMI | ECAPA-TDNN + AHC / SC | ecapa-tdnn-ami |

Восстановление знаков пунктуации

| Задача | Датасет | Тип модели | Скрипт |

|---|---|---|---|

| Восстановление знаков препинания | IWLST2012_zh | Ernie Linear | iwslt2012-punc0 |

[Установка и конфигурация](. /docs/source/install_ru.md)

Основной учебный курс Notebook

Продвинутые документы

ЛицензияМодуль синтеза речи первоначально назывался Parakeet, но теперь объединён с этим репозиторием. Если вас интересует академическое исследование этой задачи, обратитесь к общему обзору TTS. Кроме того, обзор моделей является отличным руководством для понимания процесса синтеза речи.

Для цитирования PaddleSpeech в исследовании используйте следующий формат цитирования.

@InProceedings{pmlr-v162-bai22d,

title = {{A}$^3${T}: Alignment-Aware Acoustic and Text Pretraining for Speech Synthesis and Editing},

author = {Bai, He and Zheng, Renjie and Chen, Junkun and Ma, Mingbo and Li, Xintong and Huang, Liang},

booktitle = {Proceedings of the 39th International Conference on Machine Learning},

pages = {1399--1411},

year = {2022},

volume = {162},

series = {Proceedings of Machine Learning Research},

month = {17--23 Jul},

publisher = {PMLR},

pdf = {https://proceedings.mlr.press/v162/bai22d/bai22d.pdf},

url = {https://proceedings.mlr.press/v162/bai22d.html},

}

``````markdown

<a name="вклад"></a>

## Внесение вклада в PaddleSpeech

@inproceedings{zhang2022paddlespeech,

title = {PaddleSpeech: Инструментарий для работы со звуком},

author = {Hui Zhang, Tian Yuan, Junkun Chen, Xintong Li, Renjie Zheng, Yuxin Huang, Xiaojie Chen, Enlei Gong, Zeyu Chen, Xiaoguang Hu, Dianhai Yu, Yanjun Ma, Liang Huang},

booktitle = {Демонстрационные материалы конференции Ассоциации за вычислительную лингвистику Северной Америки: технологии естественного языка 2022 года},

year = {2022},

publisher = {Ассоциация за вычислительную лингвистику},

}

@inproceedings{zheng2021fused,

title={Объединённое акустическое и текстовое кодирование для многомодальной билингвой подготовки и перевода речи},

author={Zheng, Renjie and Chen, Junkun and Ma, Mingbo and Huang, Liang},

booktitle={Международная конференция по машинному обучению},

pages={12736--12746},

year={2021},

organization={PMLR}

}

```Мы рады приветствовать вас в [Discussions](https://github.com/PaddlePaddle/PaddleSpeech/discussions) для представления проблем и в [Issues](https://github.com/PaddlePaddle/PaddleSpeech/issues) для указания найденных ошибок. Кроме того, мы очень надеемся на ваш вклад в развитие PaddleSpeech!

### Вкладчики

<p align="center">

<a href="https://github.com/zh794390558"><img src="https://avatars.githubusercontent.com/u/3038472?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/Jackwaterveg"><img src="https://avatars.githubusercontent.com/u/87408988?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/yt605155624"><img src="https://avatars.githubusercontent.com/u/24568452?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/Honei"><img src="https://avatars.githubusercontent.com/u/11361692?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/KPatr1ck"><img src="https://avatars.githubusercontent.com/u/22954146?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/kuke"><img src="https://avatars.githubusercontent.com/u/3064195?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/lym0302"><img src="https://avatars.githubusercontent.com/u/34430015?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/SmileGoat"><img src="https://avatars.githubusercontent.com/u/56786796?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/xinghai-sun"><img src="https://avatars.githubusercontent.com/u/7038341?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/pkuyym"><img src="https://avatars.githubusercontent.com/u/5782283?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/LittleChenCc"><img src="https://avatars.githubusercontent.com/u/10339970?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/qingen"><img src="https://avatars.githubusercontent.com/u/3139179?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/D-DanielYang"><img src="https://avatars.githubusercontent.com/u/23690325?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/Mingxue-Xu"><img src="https://avatars.githubusercontent.com/u/92848346?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/745165806"><img src="https://avatars.githubusercontent.com/u/20623194?<a href="https://github.com/jerryuhoo"><img src="https://avatars.githubusercontent.com/u/24245709?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/WilliamZhang06"><img src="https://avatars.githubusercontent.com/u/97937340?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/chrisxu2016"><img src="https://avatars.githubusercontent.com/u/18379485?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/iftaken"><img src="https://avatars.githubusercontent.com/u/30135920?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/lfchener"><img src="https://avatars.githubusercontent.com/u/6771821?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/BarryKCL"><img src="https://avatars.githubusercontent.com/u/48039828?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/mmglove"><img src="https://avatars.githubusercontent.com/u/38800877?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/gongel"><img src="https://avatars.githubusercontent.com/u/24390500?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/luotao1"><img src="https://avatars.githubusercontent.com/u/6836917?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/wanghaoshuang"><img src="https://avatars.githubusercontent.com/u/7534971?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/kslz"><img src="https://avatars.githubusercontent.com/u/54951765?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/JiehangXie"><img src="https://avatars.githubusercontent.com/u/51190264?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/david-95"><img src="https://avatars.githubusercontent.com/u/15189190?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/THUzyt21"><img src="https://avatars.githubusercontent.com/u/91456992?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/buchongyu2"><img src="https://avatars.githubusercontent.com/u/29157444?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/iclementine"><img src="https://avatars.githubusercontent.com/u/16222986?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/phecda-xu"><img src="https://avatars.githubusercontent.com/u/46859427?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/freeliuzc"><img src="https://avatars.githubusercontent.com/u/23568094?s=60&v=4" width=75 height=75></a><a href="https://github.com/ZeyuChen"><img src="https://avatars.githubusercontent.com/u/1371212?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/ccrrong"><img src="https://avatars.githubusercontent.com/u/101700995?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/AK391"><img src="https://avatars.githubusercontent.com/u/81195143?s=60&v=4" width=75 height=75></a>

```markdown

<a href="https://github.com/qingqing01"><img src="https://avatars.githubusercontent.com/u/7845005?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/0x45f"><img src="https://avatars.githubusercontent.com/u/23097963?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/vpegasus"><img src="https://avatars.githubusercontent.com/u/22723154?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/ericxk"><img src="https://avatars.githubusercontent.com/u/4719594?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/Betterman-qs"><img src="https://avatars.githubusercontent.com/u/61459181?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/sneaxiy"><img src="https://avatars.githubusercontent.com/u/32832641?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/Doubledongli"><img src="https://avatars.githubusercontent.com/u/20540661?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/apps/dependabot"><img src="https://avatars.githubusercontent.com/in/29110?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/kvinwang"><img src="https://avatars.githubusercontent.com/u/6442159?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/chenkui164"><img src="https://avatars.githubusercontent.com/u/34813030?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/PaddleZhang"><img src="https://avatars.githubusercontent.com/u/97284124?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/billishyahao"><img src="https://avatars.githubusercontent.com/u/96406262?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/BrightXiaoHan"><img src="https://avatars.githubusercontent.com/u/25839309?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/jiqiren11"><img src="https://avatars.githubusercontent.com/u/82639260?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/ryanrussell"><img src="https://avatars.githubusercontent.com/u/523300? s=60&v=4" width=75 height=75></a>

```s=60&v=4" width=75 height=75></a>

<a href="https://github.com/GT-ZhangAcer"><img src="https://avatars.githubusercontent.com/u/46156734?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/tensor-tang"><img src="https://avatars.githubusercontent.com/u/21351065?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/hysunflower"><img src="https://avatars.githubusercontent.com/u/52739577?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/"

```<a href="https://github.com/oyjxer"><img src="https://avatars.githubusercontent.com/u/16233945?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/JamesLim-sy"><img src="https://avatars.githubusercontent.com/u/61349199?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/limpidezza"><img src="https://avatars.githubusercontent.com/u/71760778?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/windstamp"><img src="https://avatars.githubusercontent.com/u/34057289?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/AshishKarel"><img src="https://avatars.githubusercontent.com/u/58069375?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/chesterkuo"><img src="https://avatars.githubusercontent.com/u/6285069?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/YDX-2147483647"><img src="https://avatars.githubusercontent.com/u/73375426?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/AdamBear"><img src="https://avatars.githubusercontent.com/u/2288870?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/wwhu"><img src="https://avatars.githubusercontent.com/u/6081200?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/lispc"><img src="https://avatars.githubusercontent.com/u/2833376?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/harisankarh"><img src="https://avatars.githubusercontent.com/u/1307053?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/pengzhendong"><img src="https://avatars.githubusercontent.com/u/10704539?s=60&v=4" width=75 height=75></a>

<a href="https://github.com/Jackiexiao"><img src="https://avatars.githubusercontent.com/u/18050469?s=60&v=4" width=75 height=75></a>

## Благодарности

- Огромное спасибо [HighCWu](https://github.com/HighCWu) за добавление примеров кода [VITS-aishell3](./examples/aishell3/vits) и [VITS-VC](.)/examples/aishell3/vits-vc).

- Огромное спасибо [david-95](https://github.com/david-95) за исправление ошибок в конце предложения TTS при использовании нескольких знаков препинания, а также за внедрение новых программ и данных. Добавлено новое [SSML](https://github.com/PaddlePaddle/PaddleSpeech/discussions/2538) для передней части TTS на китайском языке.

- Огромное спасибо [BarryKCL](https://github.com/BarryKCL) за оптимизацию передней части TTS на китайском языке с использованием [G2PW](https://github.com/GitYCC/g2pW).

- Огромное спасибо [yeyupiaoling](https://github.com/yeyupiaoling)/[PPASR](https://github.com/yeyupiaoling/PPASR)/[PaddlePaddle-DeepSpeech](https://github.com/yeyupiaoling/PaddlePaddle-DeepSpeech)/[VoiceprintRecognition-PaddlePaddle](https://github.com/yeyupiaoling/VoiceprintRecognition-PaddlePaddle)/[AudioClassification-PaddlePaddle](https://github.com/yeyupiaoling/AudioClassification-PaddlePaddle) за многолетнюю поддержку и советы, а также помощь в решении многих вопросов.

- Огромное спасибо [mymagicpower](https://github.com/mymagicpower) за реализацию ASR коротких аудиофрагментов и длинных аудиофрагментов на Java с использованием PaddleSpeech ([короткие аудиофрагменты](https://github.com/mymagicpower/AIAS/tree/main/3_audio_sdks/asr_sdk), [длинные аудиофрагменты](https://github.com/mymagicpower/AIAS/tree/main/3_audio_sdks/asr_long_audio_sdk)).

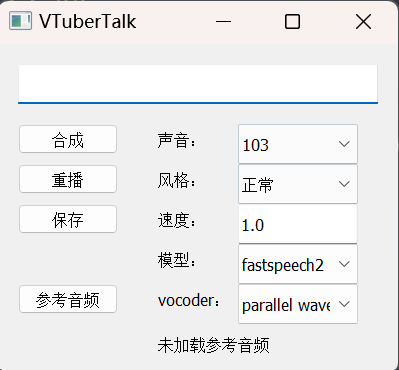

- Огромное спасибо [JiehangXie](https://github.com/JiehangXie)/[PaddleBoBo](https://github.com/JiehangXie/PaddleBoBo) за использование функции синтеза речи PaddleSpeech для создания виртуального стримера (VUP) и виртуального ютубера (VTuber).

- Огромное спасибо [745165806](https://github.com/745165806)/[PaddleSpeechTask](https://github.com/745165806/PaddleSpeechTask) за внесение моделей восстановления пунктуации.

- Огромное спасибо [kslz](https://github.com/kslz).com/kslz) за дополнение китайской документации.

- Огромное спасибо [awmmmm](https://github.com/awmmmm) за предоставление предобученной модели fastspeech2 aishell3 conformer.

- Огромное спасибо [phecda-xu](https://github.com/phecda-xu)/[PaddleDubbing](https://github.com/phecda-xu/PaddleDubbing) за создание инструмента для дублирования голоса с графическим интерфейсом пользователя на основе TTS модели PaddleSpeech.

- Огромное спасибо [jerryuhoo](https://github.com/jerryuhoo)/[VTuberTalk](https://github.com/jerryuhoo/VTuberTalk) за создание графического интерфейса пользователя для TTS и кода для создания набора данных на основе ASR.

- Огромное спасибо [vpegasus](https://github.com/vpegasus)/[xuesebot](https://github.com/vpegasus/xuesebot) за создание говорящего бота, способного слушать и отвечать на вопросы, используя ASR и TTS PaddleSpeech.

- Благодарю [chenkui164](https://github.com/chenkui164)/[FastASR](https://github.com/chenkui164/FastASR) за реализацию C++-вывода ASR для PaddleSpeech.

- Благодарю [heyudage](https://github.com/heyudage)/[VoiceTyping](https://github.com/heyudage/VoiceTyping) за создание инструмента в реальном времени для ввода голосовых данных с использованием потокового вывода ASR PaddleSpeech.

- Благодарю [EscaticZheng](https://github.com/EscaticZheng)/[ps3.9wheel-install](https://github.com/EscaticZheng/ps3.9wheel-install) за предоставление установочных пакетов с предварительно скомпилированными зависимостями для Windows без использования Visual Studio на основе Python 3.9.

- Благодарю [chinobing](https://github.com/chinobing)/[FastAPI-PaddleSpeech-Audio-To-Text](https://github.com/chinobing/FastAPI-PaddleSpeech-Audio-To-Text)com/chinobing/FastAPI-PaddleSpeech-Audio-To-Text) за использование FastAPI для реализации функции преобразования аудио в текст с помощью PaddleSpeech, включая загрузку файлов, разделение, отображение прогресса конвертации, фоновые задачи обновления и вывод в формате CSV.

- Благодарю [MistEO](https://github.com/MistEO)/[Pallas-Bot](https://github.com/MistEO/Pallas-Bot) за проект бота для QQ, использующего TTS PaddleSpeech. Кроме того, PaddleSpeech зависит от многих открытых хранилищ. Для получения дополнительной информации обратитесь к [источникам](./docs/source/reference.md).## Лицензия

PaddleSpeech предоставляется под лицензией [Apache-2.0](./LICENSE).

## Подписчики со временем

[](https://starchart.cc/PaddlePaddle/PaddleSpeech)

Вы можете оставить комментарий после Вход в систему

Неприемлемый контент может быть отображен здесь и не будет показан на странице. Вы можете проверить и изменить его с помощью соответствующей функции редактирования.

Если вы подтверждаете, что содержание не содержит непристойной лексики/перенаправления на рекламу/насилия/вульгарной порнографии/нарушений/пиратства/ложного/незначительного или незаконного контента, связанного с национальными законами и предписаниями, вы можете нажать «Отправить» для подачи апелляции, и мы обработаем ее как можно скорее.

Опубликовать ( 0 )