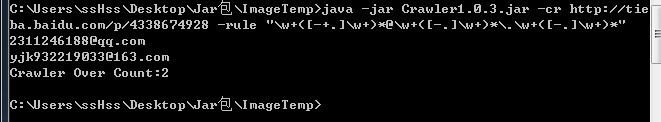

Добавлено регулярное выражение для парсинга данных

-cr URL -rule "[регулярное выражение]" лучше использовать двоеточие для разделения {другие данные} можно указать -input для записи результата в файл

-------------------------------код------------------------------ 2016.04.01

-------------------------------код------------------------------ 2016.04.01

Исправлена ошибка команды -cl, добавлен автоматический фильтр повторяющихся записей -cl URL -cq div[class=XX] -cl URL -cq div[class=xx] -file <путь к файлу> сохраняет URL построчно в указанном месте

-cq может быть <a href=""> достаточно передать a -cq a

Если есть <div class="xss"> <a ... </a> <a2>... </a> ... n</div>, то -cq div[class=xss] позволяет вытащить все URL и удалить повторяющиеся записи

-------------------------------код------------------------------ 2016.03.28

Дополнительные данные -header User-Agent@Android -cookie CookieValue -data user=x&pass=x -proxy IP:PORT -timesec время -post Команда: -v версия манипулятора Crawler -h справка по использованию Crawler -u [url] {другие данные} -cw [url] -cq k,v@k,v k=title v=div[class=XXX] {другие данные} -ci -file <путь к списку> -input <путь к входным данным> -cq k,v@k,v... {другие данные}

Команда: java -jar Crawler.jar -[опция]

-v информация о версии

-h справка по использованию

-ct [url] проверка парсинга одного сайта URL: адрес для проверки

-cw [url] [k,v] проверка извлечения информации | URL: адрес для проверки | [k,v] title,div[class=title] если несколько параметров, используйте # для разделения

-ci [urllist] [k,v] <InputResult> Сохраняет правила извлеченной информации в XML, можно использовать импорт SQL-инструментов для загрузки данных в базу данных или преобразования в другие форматы | <InputResult> Сохранение результата в каталоге вывода

-cl [url] [k,v] <InputUrllist> Сохраняет список URL для указанного URL в файле, что позволяет использовать ci для более глубокого парсинга

Примеры

-ci URL-файл правила парсера путь выходных данных

java -jar crawler.jar -ci url.txt title,h1[id=artibodyTitle]#date,span[id=pub_date]#nodes,div[id=artibody] data.xmlРезультат выполнения

Затем мы можем использовать импорт SQL-инструментов, чтобы загрузить данные в XML, а затем преобразовать его в различные форматы, такие как XML, TXT, EXCEL, WORD и т. д. Инструменты, такие как Navicat-cl используется для создания файла urllist.txt, после чего можно выполнить команду ci

Напрямую отправьте мне запрос через ISS или электронную почту, и я помогу вам улучшить это. У меня есть множество незаконченных проектов.

Завершенные задачи:Вы можете оставить комментарий после Вход в систему

Неприемлемый контент может быть отображен здесь и не будет показан на странице. Вы можете проверить и изменить его с помощью соответствующей функции редактирования.

Если вы подтверждаете, что содержание не содержит непристойной лексики/перенаправления на рекламу/насилия/вульгарной порнографии/нарушений/пиратства/ложного/незначительного или незаконного контента, связанного с национальными законами и предписаниями, вы можете нажать «Отправить» для подачи апелляции, и мы обработаем ее как можно скорее.

Комментарии ( 0 )